Briefing Wirtschaft Economy, KI, AI, LLM, Google Gemini, ChatGPT, Grok, Claude

Alle reden über KI, denken nach über die KI, haben Angst vor oder setzen Hoffnungen in die KI – und wenden KI an. In diesem Sinne hat Statista gerade eine ganze Reihe, um nicht zu schreiben eine Flut von Grafiken herausgegeben, die sich mit dem Thema KI-Offensive befassen. Dank unserer offensiven Art, uns mit der KI zu befassen, indem wir sie vermehrt für den Wahlberliner einsetzen, ist das die Gelegenheit, unsere Serie von Artikeln dazu fortzführen.

-

Im August 2025 waren wir hier angelangt: Update 2: Arbeitsplatzabbau durch KI +++ Unternehmensziele: Verschleierung, Rückwärtsgang, Spaltungspolitik +++ Goole als KI-Führer (Statista + Recherche + Kommentare) #Google #Meta #Microsoft #OpenAI

-

Und im Mai 2025 haben wir hierzu publiziert: KI treibt Stromverbrauch von Rechenzentren – Verdoppelung bis 2030 erwartet (Statista + mehr Infos + Kurzkommentar)

Wir wollen auch gar nicht verschweigen, dass die KI-Themen dem Wahlberliner guttun: Die Zugriffszahlen auf Artikel, die KI-Tags aufweisen, liegen deutlich über dem Durchschnitt unserer Beiträge. Das ist uns aber jetzt erst aufgefallen, weil wir uns nach einiger Zeit die „Absatzzahlen“ mal wieder angeschaut hatten. Zu dem Zeitpunkt war die vorliegende Wiederaufnahme der KI-Serie bereits geplant. Aber wie fangen wie an, wo setzen wir die Akzente? Es wird auch dieses Mal wieder Kritisches und einfach nur Faktisches nebeneinander geben, aber natürlich können wir nicht nur negativ über KI schreiben, wenn wir sie selbst nutzen, um a.) Zeit einzusparen und b.) vor allem Content für unsere Leser zu kreieren, den wir anders so nicht anbieten könnten. Weil wir eben zu viel Zeit für die Recherche brauchen würden und noch mehr für die Aufbereitung.

Es geht auch um Inspiration. Wir folgen gerne Vorschlägen zur Vertiefung, die KIen uns aufgrund unserer Anfragen machen, und wir hoffen, dass wir durch die Art der Fragestellung immer denen etwas voraus sind, die KI weniger intiuitiv und weniger kreativ nutzen. Mithin jenen, die grundsätzlich mit Sprache nicht so spielen können, wie das bei uns der Fall ist und die weniger assoziativ und analytisch veranlagt sind. Wir glauben aufgrund dieser Aufstellung auch, dass wir vom KI-Einsatz eher profitieren werden, als dass er uns schaden wird. Das kleine Plus gegenüber eher standardmäßigen Anfragen, das wir aufgrund langjährigem intensivem Umgang mit Sprache haben, das wollen wir nutzen. Die Art, wie unser Blog in den letzten Monaten rezipiert wird, ermutigt uns dahingehend. Aber was nutzen wir eigentlich? Und damit zur ersten Grafik, deren Inhalt uns durchaus überrascht hat:

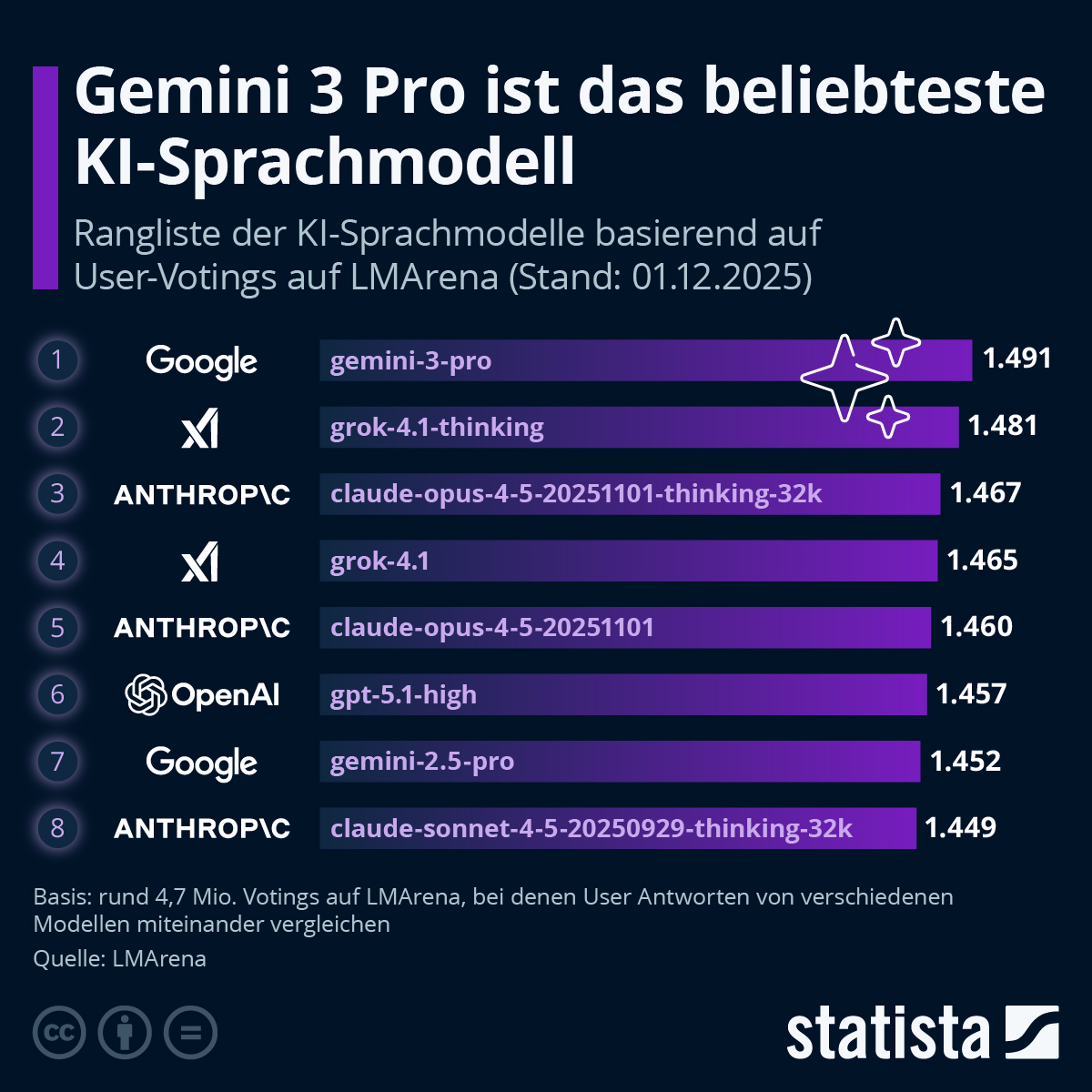

Infografik: Welches ist das beliebteste KI-Sprachmodell? | Statista

Begleittext von Statista

Googles Gemini 3 Pro ist bei KI-Sprachmodellen derzeit bei Nutzenden dieser Technologie weltweit am beliebtesten. Das zeigt eine Rangliste der Plattform LMArena, auf der große KI‑Sprachmodelle (Large Language Models, kurz LLMs) durch Gemeinschaftsvoting bewertet werden. Hierbei vergleichen Nutzende paarweise die Antworten zweier KI-Modelle und wählen aus, welche Antwort besser ist. Die Rangliste der beliebtesten Sprachmodelle basiert Anfang Dezember 2025 auf über 4,7 Millionen Votings und wird dabei laufend aktualisiert.

Auf Platz zwei liegt die Thinking-Variante von Grok 4.1, welche vom KI-Startup xAI entwickelt worden ist. xAI wurde von Elon Musk gegründet und ist eng mit Musks anderen Projekten wie Twitter/X und Tesla vernetzt, um KI-Lösungen auch in der Praxis einzusetzen. Grok wurde Ende November 2025 mit zwei Varianten veröffentlicht: einer schnellen „non‑reasoning“-Variante und der tiefer analysierenden „Thinking“-Variante. Auf dem dritten Platz folgt die Thinking-Variante von Claude Opus 4.5. Dieses KI-Modell wurden von Anthropic entwickelt – einem KI-Unternehmen aus San Francisco, das aus ehemaligen Mitarbeitenden von früheren KI‑Unternehmen hervorging und sich auf leistungsfähige, sicherheitsorientierte Sprachmodelle spezialisiert hat.

Das in Deutschland vergleichsweise beliebte und bekannte KI-Sprachmodell ChatGPT von OpenAI liegt derzeit nur auf Platz sechs der Rangliste. Dies veranschaulicht, dass sich der KI‑Markt rasch entwickelt: Neue Versionen werden veröffentlicht und dies verschiebt die Rangfolge regelmäßig. Ein Modell, das vor einigen Monaten führend war, kann heute schon überholt sein. Die Rangliste der LMArena wird fortlaufend mindestens wöchentlich aktualisiert.

Dadurch, dass auf LMArena viele populäre, aktuelle LLMs sind enthalten, erhält man einen vergleichenden Überblick über den aktuellen KI-Markt. Hierbei ist allerdings zu berücksichtigen, dass die subjektiven Einschätzungen der Nutzenden die Ranglisten generieren. Es wird von den Betreibenden der Plattform nicht objektiv geprüft, welches Modell faktenmäßig besser, sicherer oder effizienter ist. Ein Modell, das kreativ oder stilistisch überzeugend wirkt, kann somit bevorzugt werden, auch wenn es faktisch ungenau sein sollte.

Recherche

Wir verwenden den inoffiziellen Begriff „LLMArena“, obwohl es offiziell immer noch „LMArena“ heißt, aber alle oben genannten Module sind LLM, zu dem spezifischen Wettrennen der großen Sprachmodule passt also LLMArena besser.

Also, wir legen es hier einmal offen. Wir verwenden überwiegend ChatGPT 5.1, auch gerne in der Thinking-Version. Und die Rangfolge in der Grafik ist schon nicht mehr aktuell, denn jetzt liegt ChatGPT 5.1 thinking wieder auf Platz 3, führend aber ist nach wie vor Gemini 3 Pro. Man sieht ja auch anhand der Punktzahlen, wie dicht die Spitzenmodelle beieinander liegen. Und es ist sehr interessant, wie unterschiedlich Gemini und ChatGPT auf unsere Frage „Was ist LLMArena“ reagiert haben. Uns gefällt die hübsch aufgemacht und sehr klar strukturierte und ausführliche GPT-Antwort nach wie vor sehr gut – aber wir wissen natürlich, dass es unzählige unterschiedliche Anforderungen gibt, die von den führenden LLM-Modellen unterschiedlich gut bewältigt werden. Bei uns geht es vor allem um Textproduktion und eine Darstellung, die sich in letzter Zeit auch grafisch auf verblüffende Weise verbessert hat und sich sehr gut in den WordPress-Editor integrieren lässt. Außerdem nutzen wir ChatGPT über verschiedene Zugänge, zum einen direkt, aber auch über den MS-Copilot. Leider nicht mehr in der engeren Wahl: Perplexity, nachdem unsere Bonus-Pro-Meilen beendet sind. Nehmen wir nur noch, um Kontingente bei den anderen LLM zu sparen für einfache Anfragen und wenn es um schnelle Tabellen und dergleichen geht.

Witzig: Für die eine KI ist LLMArena sehr wohl etwas wie ein Benchmarking-Modul, für die andere nicht. Liegt vermutlich an deren aktueller Platzierung ;-) Im Grunde müsste man, wenn man den klassischen journalistischen Gegencheck auf moderne KI-Verhältnisse übertragen will, ohnehin dieselbe Frage an zwei bevorzugte LLM vergeben, dann vergleichen und bei Unstimmigkeiten mindestens eine dritte Meinung einholen, ganz wie in bestimmten Gutachten-Verfahren. Und es kann immer noch sein, dass alle falsch liegen. Deswegen das eigene Denken bitte nicht vergessen. Durch unseren einigermaßen geübten Umgang mit Statistiken fallen uns Faktenfehler relativ häufig auf, aber wenn es um Zitate geht, wird es schon schwieriger, und bei Bewertungen und Einschätzungen kann das Ergebnis nur subjektiv sein. Wie bei uns selbst.

Nun aber, was GPT 5.1 zu LLMArena geschrieben hat:

LLM Arena (meist Chatbot Arena genannt, offiziell von LMSYS) ist eine öffentliche Online-Plattform, auf der man große Sprachmodelle (LLMs) direkt miteinander vergleichen kann – durch anonyme Live-Duelle.

Die bekannteste Adresse ist:

„Chatbot Arena“ von LMSYS

🔹 Kurz erklärt

Auf LLMArena:

-

bekommst du zwei unbekannte KI-Modelle gleichzeitig

-

stellst eine einzige Frage

-

siehst zwei Antworten nebeneinander

-

wählst:

-

✅ Antwort A ist besser

-

✅ Antwort B ist besser

-

⚖️ Unentschieden

-

Die Modelle sind anonym, damit kein Markenbias entsteht.

Aus Millionen solcher Vergleiche entsteht ein Elo-Ranking, ähnlich wie beim Schach.

🔹 Wozu ist LLMArena gut?

✅ 1. Unabhängiger Modell-Vergleich

Statt Herstellerangaben bekommst du:

-

echte Nutzerurteile

-

reale Qualitätsvergleiche

-

täglich aktualisierte Ranglisten

✅ 2. Forschungsplattform

Universitäten & KI-Labs nutzen die Daten, um:

-

Modellqualität zu messen

-

Fortschritte objektiv zu vergleichen

-

Halluzinationen, Logik, Stil usw. zu bewerten

✅ 3. Gratis Testlabor

Du kannst dort kostenlos testen:

-

GPT-Modelle

-

Claude

-

Gemini

-

LLaMA, Mistral u. a.

Ohne Accounts, ohne API-Kosten.

🔹 Was misst das Ranking konkret?

Die Nutzer bewerten u. a.:

-

✅ Faktengenauigkeit

-

✅ Logik & Argumentationsfähigkeit

-

✅ Sprachqualität

-

✅ Kreativität

-

✅ Sicherheitsverhalten

-

✅ Programmierqualität

Das Elo-System bedeutet:

-

+50 Elo ≈ deutlich besser

-

+100 Elo ≈ klarer Qualitätsunterschied

🔹 Warum LLMArena wichtig geworden ist

Früher:

„Firma X sagt, ihr Modell ist das beste.“

Heute:

„Millionen Nutzer haben Modell X gegen Y getestet.“

➡️ LLMArena hat sich zum De-facto-Standard für KI-Vergleiche entwickelt.

Sogar:

-

OpenAI

-

Anthropic

-

Google

-

Meta

beobachten diese Rankings sehr genau.

🔹 Was LLMArena nicht ist

❌ Kein offizieller Industriestandard

❌ Keine reine Benchmark-Messung

❌ Keine Sicherheitszertifizierung

✅ Sondern: kollektiver Praxistest

🔹 Mini-Fazit

LLMArena ist so etwas wie der „Stiftung Warentest für KI-Chatbots“ – nur live, crowdsourced und ständig aktuell.

Wenn du möchtest, kann ich dir auch erklären:

-

wie zuverlässig diese Rankings wirklich sind

-

wo ihre methodischen Schwächen liegen

-

oder wie gut man daraus Kauf-/Aboentscheidungen ableiten kann.

Dieses Mal haben wir die Einladung zur Vertiefung im Text stehen lassen, damit klar ist, wie unsere Konversationen zuweilen verlaufen. Und nun, was Gemini dazu verfasst hat:

Hier sind die aktuellen Top-Modelle der WebDev Arena, die sich speziell auf Webentwicklung (HTML, CSS, JavaScript, React, Vue, SQL, etc.) konzentriert.

Da die Programmierung oft logisches Schlussfolgern erfordert, dominieren hier zunehmend Modelle mit speziellen „Thinking“-Fähigkeiten (Chain-of-Thought).

🥇 Aktuelles Leaderboard: WebDev Arena (Ende 2025)

|

Rang |

Modell |

Stärke im WebDev-Kontext |

|

1 |

Gemini 3 Pro (Google) |

Gilt als extrem stark in der Code-Generierung und Fehlerbehebung. Besonders bei der Integration von aktuellen Frameworks und komplexen Refactorings zeigt es eine sehr hohe Genauigkeit. |

|

2 |

Claude Opus 4.5 Thinking (Anthropic) |

Anthropic-Modelle sind traditionell sehr stark im Coden. Die „Thinking“-Variante plant die Architektur einer Web-App oft besser voraus, bevor sie Code ausgibt, was „Halluzinationen“ bei APIs reduziert. |

|

3 |

GPT-5.1 High (OpenAI) |

Der Nachfolger von GPT-4o. Sehr solide und schnell, oft bevorzugt für „Quick Fixes“ oder Standard-Boilerplate-Code, auch wenn es bei extrem komplexen Logik-Ketten manchmal knapp hinter Gemini oder Claude liegt. |

🛠️ Was macht die WebDev Arena besonders?

Im Gegensatz zur allgemeinen Text-Arena werden hier spezifische Fähigkeiten getestet:

-

Framework-Wissen: Wie gut kennt das Modell Next.js 15, Vue 4 oder Svelte 5?

-

Debugging: Kann das Modell einen Fehler in einem Stack Trace finden und korrigieren?

-

UI/UX-Verständnis: Kann es CSS-Code generieren, der tatsächlich so aussieht wie beschrieben?

Zusatz-Info: Es gibt oft ein Kopf-an-Kopf-Rennen zwischen Claude und Gemini in diesem Bereich. Viele Entwickler nutzen Claude für die Architektur (Planung) und Gemini oder GPT für die schnelle Implementierung einzelner Funktionen.

Möchten Sie wissen, welches Modell für einen bestimmten Tech-Stack (z. B. Python/Django vs. JavaScript/React) aktuell am besten abschneidet?

Bei Gemini merkt man direkt, es hält sich für ein LLM für IT-Profis. Allerdings ist es den Umgang mit uns auch noch nicht gewohnt, weil wir es just für den vorliegenden Artikel zum ersten Mal befragt haben. Es kommt aber nun „oben an“, bei den angepinnten Tabs. Nachteil gegenüber GPT: Um es problemlos in unsere Office-Datei einfügen zu können (ohne Umformatierung) und dann in WordPress, muss erst ein Google Doc angelegt werden.

TH / LLM-Arena-Recherche durch KI erstellt

Entdecke mehr von DER WAHLBERLINER

Melde dich für ein Abonnement an, um die neuesten Beiträge per E-Mail zu erhalten.